58,99 zł

Dowiedz się więcej.

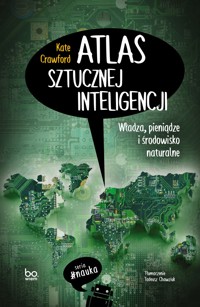

- Wydawca: Wydawnictwo Uniwersytetu Jagiellońskiego

- Kategoria: Literatura faktu

- Język: polski

Nieodwracalna transformacja naszego życia, jaką niesie ze sobą wynalezienie sztucznej inteligencji, staje się faktem. Czy znamy ukryte koszty tej przełomowej technologii? Czy wiemy, czyim służy interesom? I jaki ma wpływ na społeczeństwo?

Kate Crawford obala mity, jakoby sztuczna inteligencja była bezcielesna, obiektywna czy niezbędna. Udowadnia, że to narzędzie wyzysku w rękach władzy, policji, wojska i korporacji oraz podłoże narastających nierówności. Funkcjonowanie systemów AI nie byłoby możliwe bez nadmiernej eksploatacji zasobów energetycznych i mineralnych, wykorzystania taniej siły roboczej i niekontrolowanego pozyskiwania danych.

Atlas sztucznej inteligencji stanowi swoistą mapę teraźniejszości: miejsc, ludzi i relacji. Pomaga zrozumieć rolę AI we współczesnym świecie. Jest cenną przeciwwagą dla bezkrytycznych zachwytów nad sztuczną inteligencją oraz zaproszeniem do świadomego i odpowiedzialnego korzystania z technologii informacyjnej.

Czy wiesz, że:

- rekruterzy w wielkich korporacjach wykorzystują narzędzia do przechwytywania i analizy wyrazu twarzy i mowy ciała?

- niektóre stacje robocze w halach produkcyjnych są wyposażone w czujniki, które na bieżąco informują o temperaturze ciała pracowników i ich fizycznej odległości od innych osób?

- jedna z sieci restauracji zainstalowała w kuchniach systemy widzenia komputerowego sprawdzające, czy personel przygotowuje pizzę zgodnie ze standardami?

„Krytyczne, ale bardzo oryginalne spojrzenie na problemy generowane przez dynamiczny rozwój sztucznej inteligencji. Kate Crawford analizuje nie tylko techniczne aspekty AI, lecz także jej wpływ na pracę, prywatność, władzę oraz środowisko. Pozycja obowiązkowa zarówno dla entuzjastów, jak i sceptyków szeroko rozumianej sztucznej inteligencji”.

Dr Kamil Filipek, socjolog i data scientist, dyrektor Centrum Sztucznej Inteligencji i Modelowania Komputerowego UMCS

„Śledząc rozwój AI, jej mitologię, etykę i politykę, Atlas sztucznej inteligencji uświadamia nam, że opowiadane o niej historie są równie istotne, jak modele matematyczne, na których systemy te są zbudowane”.

Ruha Benjamin, autorka książki Race After Technology: Abolitionist Tools for the New Jim Code

„Wnikliwa książka Kate Crawford pokazuje, że sztuczna inteligencja to nie deus ex machina, ale zbiór dehumanizujących i wykluczających praktyk, z których większość z nas nie zdaje sobie sprawy”.

Sue Halpern, New York Review of Books

„Niezbędna lektura. Przechodząc od wydobywania litu do ekstrakcji danych, od wyzysku pracowników do rządowej inwigilacji, Atlas sztucznej inteligencji doskonale pokazuje, jak powstaje inteligencja. Anemiczne wołanie o »etykę« zastępuje wnikliwymi obserwacjami na temat degradacji środowiska, akumulacji kapitału i warunków pracy, dzięki którym AI istnieje”.

Wendy Hui Kyong Chun, Katedra Nowych Mediów Uniwersytetu Simona Frasera, Kanada

„Książka ujawnia ciemną stronę sukcesu sztucznej inteligencji. (…) Oparta na gruntownych badaniach i świetnie napisana”.

Virginia Dignum, Nature

Ebooka przeczytasz w aplikacjach Legimi lub dowolnej aplikacji obsługującej format:

Liczba stron: 402

Rok wydania: 2024

Podobne

Marka wydawnicza Bo.wiem

Seria #nauka

PROJEKT SERII

Marta Jaszczuk

Konsultacja merytoryczna

dr Kamil Filipek

Projekt okładki

Sebastian Wojnowski

Grafiki na okładce

Adobe Stock (mapa – Dariaren; płyta główna na mapie – Bank215;

płyta główna w tle – Singha Songsak)

Ilustracje poprzedzające rozdziały

Vladan Joler

Tytuł oryginału: Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence

Copyright © 2021 by Kate Crawford · Originally published by Yale University Press

Copyright © for the Polish translation by Tadeusz Chawziuk, 2024

Copyright © for the Polish edition by Wydawnictwo Uniwersytetu Jagiellońskiego, 2024

Wydanie I, Kraków 2024

All rights reserved

Niniejsza książka stanowi utwór chroniony na podstawie ustawy o prawie autorskim i prawach pokrewnych. Prawami do tego utworu dysponuje Wydawca – Wydawnictwo Uniwersytetu Jagiellońskiego. Bez zgody Wydawcy niedopuszczalne jest kopiowanie, rozpowszechnianie lub inne korzystanie z niniejszej książki w całości lub z jej fragmentów z wyjątkiem dozwolonego użytku osobistego lub publicznego.

ISBN 978-83-233-5326-3 (druk)

ISBN 978-83-233-7516-6 (epub, mobi)

Wydawnictwo Uniwersytetu Jagiellońskiego

Redakcja: ul. Michałowskiego 9/2

31-126 Kraków

tel. +48 12 663 23 80

Dystrybucja: tel. +48 12 631 01 97

tel. kom. +48 506 006 674, e-mail: [email protected]

Konto: PEKAO SA, nr 80 1240 4722 1111 0000 4856 3325

www.bowiem.wuj.pl

Dla Elliotta i Margaret

Wprowadzenie

Najmądrzejszy koń świata

Pod koniec XIX wieku Europę zauroczył koń o imieniu Hans. Sprytny Hans był niesamowity: potrafił rozwiązywać zadania matematyczne, podawał godzinę, rozpoznawał dni w kalendarzu, rozróżniał tony muzyczne oraz zapisywał słowa i zdania. Ludzie schodzili się, aby podziwiać, jak niemiecki ogier wystukuje kopytem odpowiedzi na złożone pytania i nigdy się przy tym nie myli. „Ile jest dwa dodać trzy?” – Hans pilnie stukał kopytem w ziemię pięć razy. „Jaki jest dziś dzień tygodnia?” – koń uderzał kopytem, wskazując poszczególne litery na specjalnie zbudowanej tablicy, i w ten sposób podawał poprawną odpowiedź. Hans radził sobie nawet z bardziej złożonymi pytaniami, takimi jak: „Myślę o pewnej liczbie. Odejmuję od niej dziewięć i zostaje mi trzy. O jakiej liczbie myślę?”. W 1904 roku Sprytny Hans był międzynarodową gwiazdą, a New York Times nazwał go „cudownym koniem z Berlina, który potrafi prawie wszystko, a jedynie, czego nie potrafi, to mówić”1.

Wilhelm von Osten, trener Hansa i emerytowany nauczyciel matematyki, od dawna był zafascynowany inteligencją zwierząt. Wcześniej próbował uczyć liczb kardynalnych młode koty i niedźwiedzie, ale dopiero gdy zaczął pracować z koniem, odniósł sukces. Najpierw nauczył Hansa liczyć. Trzymając zwierzę za nogę, pokazywał liczbę i wystukiwał ją na jego kopycie. Wkrótce Hans zaczął sam bezbłędnie wystukiwać proste sumy. Potem von Osten wprowadził tablicę z wypisanym alfabetem, aby Hans mógł wystukać na niej numer każdej litery. Po dwóch latach treningu von Osten był zdumiony, jak dobrze zwierzę radzi sobie z wyrafinowanymi koncepcjami. Zabrał więc Hansa w trasę, aby go pokazywać jako dowód na to, że zwierzęta rozumują. Hans stał się wiralową sensacją belle époque.

Wiele osób było jednak sceptycznie nastawionych, a niemieckie kuratorium oświaty powołało komisję do spraw weryfikacji twierdzeń von Ostena. Przewodniczącymi byli psycholog i filozof Carl Stumpf oraz jego asystent Oskar Pfungst, a w jej skład wchodzili między innymi dyrektor cyrku, emerytowany nauczyciel, zoolog, lekarz weterynarii i oficer kawalerii. Po długich przesłuchaniach Hansa, zarówno w obecności tresera, jak i bez niego, koń w dalszym ciągu udzielał poprawnych odpowiedzi, a komisja nie dopatrzyła się oszustwa. Jak pisał później Pfungst, Hans występował przed „tysiącami widzów, miłośników koni, pierwszorzędnych treserów, a w toku wielomiesięcznych obserwacji ani jeden z nich nie był w stanie wykryć jakichkolwiek sygnałów” między pytającym a koniem2.

Wilhelm von Osten i Sprytny Hans

Komisja uznała, że metody, za pomocą których uczono Hansa, przypominały raczej „nauczanie dzieci w szkołach podstawowych” niż tresurę zwierząt i że były „godne zbadania naukowego”3. Stumpf i Pfungst nadal jednak mieli wątpliwości. Szczególnie zaniepokoiło ich jedno odkrycie: gdy pytający nie znał rozwiązania zagadki lub stał zbyt daleko, Hans rzadko udzielał poprawnej odpowiedzi. To doprowadziło Pfungsta i Stumpfa do przypuszczenia, że być może Hans odczytuje jakieś nieintencjonalnie wysyłane komunikaty, dzięki którym udziela poprawnych odpowiedzi.

Jak czytamy w książce Pfungsta z 1911 roku, ta intuicja okazała się trafna: postawa pytającego, jego oddech i wyraz twarzy ulegały subtelnym zmianom w chwili, gdy Hans zbliżał się do poprawnej odpowiedzi, co skłaniało go do zaniechania dalszego stukania4. Pfungst w późniejszym czasie przetestował tę hipotezę na ludziach i ją potwierdził. Najbardziej fascynujące w tym odkryciu było dla niego to, że pytający na ogół nie byli świadomi tego, iż dostarczają koniowi wskazówek. Pfungst orzekł, że rozwiązaniem zagadki Sprytnego Hansa są komunikaty nieświadomie wysyłane przez osoby zadające pytania5. Koń był szkolony w ten sposób, aby uzyskiwał rezultaty, które pragnął ujrzeć jego właściciel – widzowie czuli jednak, że to nie to samo, co nadzwyczajna inteligencja, którą przypisywali zwierzęciu.

Historia Sprytnego Hansa fascynuje z wielu punktów widzenia: zależności między pragnieniem, złudzeniem a działaniem; zarabiania pieniędzy na pokazach naukowych; tego, jak antropomorfizujemy to, co nieludzkie; sposobu, w jaki powstają uprzedzenia; wykorzystywania pojęcia inteligencji jako narzędzia władzy. Hans stał się inspiracją dla psychologicznego terminu „efekt Sprytnego Hansa” lub „efekt oczekiwań obserwatora”, który oznacza rodzaj pułapki pojęciowej, gdy na badanych wpływają nieumyślne wskazówki udzielane przez eksperymentatorów. Relacja między von Ostenem a Hansem ukazuje złożone mechanizmy, na mocy których uprzedzenia wkradają się do systemów, i to, jak badający wikłają się w badane zjawiska. Historia Hansa jest przywoływana w uczeniu maszynowym jako przestroga, że nie zawsze wiemy, czego nauczył się model z danych treningowych6. System zachowujący się poprawnie w fazie treningu może tworzyć zupełnie błędne prognozy, gdy otrzyma nowe dane.

Tak dochodzimy do najważniejszego pytania tej książki: jak „powstaje” inteligencja i do jakich pułapek może prowadzić ten proces? Na pierwszy rzut oka historia o Sprytnym Hansie opowiada o tym, jak pewien człowiek stworzył inteligencję, trenując konia, aby postępował zgodnie ze wskazówkami i naśladował ludzką zdolność poznawczą. Praktyka tworzenia inteligencji obejmuje jednak znacznie więcej aspektów. Przedsięwzięcie musiało zostać potwierdzone autorytetem wielu instancji, w tym uniwersytetów, szkół, nauki, opinii publicznej i wojska. Był też rynek dla von Ostena i jego niezwykłego konia – emocjonalnych i ekonomicznych inwestycji, które napędzały wycieczki, artykuły w gazetach i wykłady. Oficjalne organy władzy spotykały się po to, by mierzyć i testować umiejętności konia. Rolę w konstruowaniu inteligencji Hansa odegrała cała konstelacja interesów ekonomicznych, kulturalnych oraz naukowych i mogła ona zyskać lub stracić w zależności od tego, czy inteligencja konia okaże się niezwykła, czy też nie.

Widzimy w tym działaniu dwie odrębne mitologie. Pierwszym mitem jest to, że systemy nieludzkie (komputery lub konie) są odzwierciedleniem ludzkiego umysłu. Ten punkt widzenia zakłada, że dzięki odpowiedniemu szkoleniu lub wystarczającym zasobom można stworzyć od podstaw inteligencję podobną do ludzkiej – pomijając to, że człowiek ma ciało, jest uwikłany w relacje z innymi ludźmi i osadzony w szerszym ekosystemie. Drugi mit głosi, że inteligencja jest samoistna, jakby była naturalnym bytem, odrębnym od czynników społecznych, kulturowych, historycznych lub politycznych. W rzeczywistości przez wieki pojęcie inteligencji wyrządziło ogromne szkody i było używane do usprawiedliwiania stosunków dominacji, od niewolnictwa po eugenikę7.

Mity te widać szczególnie wyraźnie w dziedzinie sztucznej inteligencji, gdzie od połowy XX wieku jak aksjomat traktowane jest przekonanie, że inteligencję ludzką można formalizować i że jest reprodukowalna przez maszyny. Tak jak inteligencję Hansa, starannie rozwijaną jak u dziecka w szkole, uważano za podobną do ludzkiej, tak systemy AI niejednokrotnie opisywano jako co prawda proste, ale zasadniczo podobne do ludzkiej inteligencji. Alan Turing w 1950 roku przewidywał, że „pod koniec tego stulecia używanie słów i ogólna opinia ludzi wykształconych zmieni się tak bardzo, że można będzie mówić o maszynach myślących, nie spodziewając się sprzeciwu”8. W 1958 roku matematyk John von Neumann twierdził, że ludzki układ nerwowy jest „na pierwszy rzut oka cyfrowy”9. Profesor MIT Marvin Minsky na pytanie, czy maszyny mogą myśleć, odpowiedział: „Oczywiście, że maszyny mogą myśleć; my możemy, a jesteśmy »maszynami z mięsa«”10. Ale nie wszyscy dali się przekonać. Joseph Weizenbaum, jeden z pionierów AI i twórca chatbota ELIZA, sądził, że wizja ludzi jako systemów przetwarzania informacji opiera się na uproszczonym pojęciu inteligencji i że napędza ono „perwersyjną, wielką fantazję” o maszynie, która uczyłaby się „tak jak dziecko”11.

Jest to jeden z głównych spornych wątków w historii sztucznej inteligencji. W 1961 roku MIT zorganizował przełomową serię wykładów pod tytułem „Zarządzanie a komputer przyszłości”. Udział wzięło wybitne grono informatyków, w tym Grace Hopper, J.C.R. Licklider, Marvin Minsky, Allen Newell, Herbert Simon i Norbert Wiener. Uczestnicy omawiali szybko zachodzące zmiany w przetwarzaniu cyfrowym. Na zakończenie John McCarthy dowodził ze swadą, że różnice między ludzkimi zadaniami a zadaniami maszyny są pozorne. Po prostu niektóre ludzkie zadania są skomplikowane, dlatego sformalizowanie i rozwiązanie ich przez maszyny musi zająć więcej czasu12.

Profesor filozofii Hubert Dreyfus zgłosił swoje votum separatum, zaskoczony tym, że inżynierowie „nie biorą nawet pod uwagę możliwości, że mózg mógłby przetwarzać informacje zupełnie inaczej niż komputer”13. W późniejszej pracy What Computers Can’t Do (Czego komputery nie potrafią) Dreyfus wskazał, że inteligencja i wiedza człowieka opierają się na wielu procesach nieświadomych i podświadomych, podczas gdy komputer wymaga, aby wszystkie procesy i dane były jawne i sformalizowane14. Dlatego na potrzeby komputerów mniej formalne aspekty inteligencji muszą zostać wyabstrahowane, wyeliminowane lub przybliżone, a wskutek tego komputery nie są w stanie tak przetwarzać informacji o sytuacjach, jak robią to ludzie.

Od lat 60. XX wieku w dziedzinie AI wiele się zmieniło, między innymi dokonało się przejście od systemów symbolicznych do technik uczenia maszynowego, w których pokładano być może przesadne nadzieje. Wczesne spory o możliwości AI w znacznej mierze zostały zapomniane, a sceptycyzm zanikł. Od pierwszej dekady XXI wieku sztuczna inteligencja przeżywa okres gwałtownego rozwoju jako dziedzina nauki i przemysłu. Kilka potężnych firm informatycznych wdraża systemy AI operujące w skali globalnej i znów systemy te są wynoszone pod niebiosa jako porównywalne do inteligencji ludzkiej, a nawet ją przewyższające.

Historia Sprytnego Hansa przypomina nam jednak również to, jak wąsko rozpatrujemy lub rozpoznajemy inteligencję. Hansa nauczono naśladować rozwiązywanie zadań z bardzo ograniczonego zakresu: dodawanie, odejmowanie i literowanie wyrazów. Odzwierciedla to ograniczone wyobrażenie o możliwościach koni czy ludzi. Hans dokonał także rzeczy niezwykłych w zakresie komunikacji międzygatunkowej, występów przed publicznością i cierpliwości, ale tego nie zakwalifikowano jako inteligencję. Jak to ujęła Ellen Ullman, pisarka i inżynierka, przekonanie, że umysł niewiele różni się od komputera, „na dziesięciolecia skaziło myślenie w informatyce i kognitywistyce”, stanowiąc coś w rodzaju grzechu pierworodnego tej dziedziny15. Chodzi o ideologię dualizmu kartezjańskiego w sztucznej inteligencji, która pojmuje ją wąsko jako inteligencję bezcielesną, pozbawioną wszelkiego związku ze światem materialnym.

Czym jest sztuczna inteligencja (AI)? Ani sztuczna, ani inteligentna

Postawmy proste pytanie: czym jest sztuczna inteligencja? Gdy zapytamy o to kogoś na ulicy, wymieni zapewne Siri Apple’a, chmurę Amazona, samochody Tesli lub wyszukiwarkę Google. Gdy zapytamy ekspertów od uczenia głębokiego, udzielą zapewne technicznej odpowiedzi o tym, że sieci neuronowe składają się z dziesiątek warstw otrzymujących etykietowane dane, o przypisanych wagach i progach, oraz klasyfikujących dane w sposób, którego na razie nie umiemy w pełni wyjaśnić16. Profesor Donald Michie w 1978 roku, omawiając systemy eksperckie, opisał sztuczną inteligencję jako takie udoskonalenie wiedzy, które „zapewnia niezawodność i sprawność kodyfikacji znacznie przewyższające poziom, jaki mógłby osiągnąć ludzki ekspert – teraz lub kiedykolwiek w przyszłości”17. W jednym z najpopularniejszych podręczników Stuart Russell i Peter Norvig piszą, że AI jest próbą zrozumienia i budowy inteligentnych bytów. „Inteligencja dotyczy przede wszystkim działania racjonalnego” – zauważają. „W idealnym przypadku inteligentny agent podejmuje najlepsze możliwe działanie w danej sytuacji”18.

Każda definicja sztucznej inteligencji wyznacza ramy tego, jak później będzie ona rozumiana, mierzona, oceniana i wdrażana. Jeżeli sztuczną inteligencję definiuje się poprzez marki konsumenckie w imieniu korporacyjnej infrastruktury, to horyzont jest z góry wyznaczony przez marketing i reklamę. Jeżeli systemy AI postrzega się jako bardziej niezawodne lub racjonalne od jakiegokolwiek ludzkiego eksperta, zdolne do wybierania „najlepszych możliwych sposobów postępowania”, to można pomyśleć, że powinno się im ufać przy podejmowaniu ważnych decyzji w zakresie zdrowia, edukacji czy wymiaru sprawiedliwości. Jeśli uwaga skupia się jedynie na konkretnych technikach algorytmicznych, to mogłoby sugerować, że liczy się wyłącznie nieprzerwany postęp techniczny, pomijający koszty obliczeniowe takiego podejścia i jego dalekosiężny wpływ na planetę.

W tej książce twierdzę, że sztuczna inteligencja nie jest ani sztuczna, ani inteligentna. Sztuczna inteligencja jest ucieleśniona i materialna, powstaje z naturalnych zasobów, paliwa, ludzkiej pracy, infrastruktury, logistyki, historii i klasyfikacji. Systemy AI nie są autonomiczne, racjonalne ani zdolne do rozpoznania czegokolwiek bez kosztownego obliczeniowo trenowania na wielkich zbiorach danych lub z określonymi z góry zasadami i nagrodami. W istocie taka sztuczna inteligencja, jaką znamy, zależy od szerszych struktur politycznych i społecznych. Ze względu na ogrom kapitału potrzebnego do budowy sztucznej inteligencji w wielkiej skali i na to, jakie sposoby postrzegania ona optymalizuje, jej systemy ostatecznie muszą być projektowane tak, aby służyły dominującym interesom. W tym sensie sztuczna inteligencja jest manifestacją władzy.

W tej książce przyjrzymy się temu, jak powstaje sztuczna inteligencja w najszerszym rozumieniu, a także jakie siły – ekonomiczne, polityczne, kulturowe i historyczne – ją kształtują. Gdy powiążemy AI z szerszymi strukturami i systemami społecznymi, unikniemy wyobrażenia, że jest ona domeną czysto techniczną. Na fundamentalnym poziomie sztuczna inteligencja to techniczne i społeczne praktyki, instytucje i infrastruktura, polityka i kultura. Obliczeniowy rozum i ucieleśniona praca są ze sobą ściśle splecione: systemy AI odzwierciedlają społeczne relacje i rozumienie świata, jak również je wytwarzają.

Warto zauważyć, że termin „sztuczna inteligencja” może powodować dyskomfort u informatyków. Określenie to było używane – raz częściej, raz rzadziej – w ciągu ostatnich dziesięcioleci i pojawiało się częściej w marketingu niż w języku badaczy. W literaturze technicznej spotykamy się raczej z „uczeniem maszynowym”. Nazwa „sztuczna inteligencja” pojawia się niejednokrotnie w związku z wnioskami o finansowanie, kiedy inwestorzy wyciągają książeczki czekowe, lub gdy badacze pragną zainteresować prasę nowym odkryciem naukowym. W związku z tym to wyrażenie jest albo uwielbiane, albo odrzucane, co powoduje, że jego znaczenie podlega ciągłym zmianom. Sama używam określenia „sztuczna inteligencja” na oznaczenie potężnej przemysłowej struktury obejmującej politykę, pracę, kulturę i kapitał. Mówiąc zaś o „uczeniu maszynowym”, mam na myśli wiele technicznych podejść (które zresztą także mają społeczny i infrastrukturalny charakter, choć o tym rzadko się wspomina).

Są jednak istotne powody, dla których tak bardzo skupiono się na postępie technicznym – przełomach algorytmicznych, stopniowym ulepszaniu produktów i rosnącej wygodzie. Zawężona, abstrakcyjna analiza dobrze służy strukturom władzy w miejscu, w którym krzyżują się technologia, kapitał i zarządzanie. W celu zrozumienia, że sztuczna inteligencja ma z zasady polityczny charakter, musimy wykroczyć poza sieci neuronowe, statystyczne rozpoznawanie wzorców i zapytać o to, co i dla kogo się optymalizuje, a także kto podejmuje decyzje. Potem możemy prześledzić implikacje takich wyborów.

AI jako atlas

W jaki sposób pojęcie atlasu może być pomocne w zrozumieniu tego, jak powstaje sztuczna inteligencja? Atlas nie jest zwykłą książką. To nagromadzenie niepodobnych do siebie części, map o różnej rozdzielczości – od zdjęcia satelitarnego planety po powiększone szczegóły archipelagów. Otwierając atlas, możemy poszukiwać informacji o konkretnym miejscu, ale możemy również podążać za ciekawością, wchodząc na nieoczekiwane drogi i przyjmując nowe perspektywy. Jak zauważyła historyczka nauki Lorraine Daston, wszystkie atlasy naukowe chcą wytrenować oko, aby skupiało się na konkretnych, wymownych szczegółach i istotnych cechach19. Atlas przekazuje pewien sposób patrzenia na świat potwierdzony autorytetem nauki – oraz skalami, proporcjami, szerokością i długością geograficzną – a także pewne poczucie formy i spójności.

Jednak atlas jest w takim samym stopniu zbiorem naukowym, co aktem twórczym – interwencją subiektywną, polityczną i estetyczną. Francuski filozof Georges Didi-Huberman uważa, że atlas leży na granicy estetycznego paradygmatu widzenia i epistemicznego paradygmatu wiedzy. Łącząc jedno z drugim, autor podważa pogląd, że nauka i sztuka nie mają ze sobą nic wspólnego20. Atlas daje możliwość ponownego odczytania świata, powiązania części pozornie zupełnie odmiennych oraz ich „reedycji i złożenia na nowo, bez pretensji do podsumowania lub wyczerpania tematu”21.

Najbardziej lubiane przeze mnie wyjaśnienie, dlaczego podejście kartograficzne może być pomocne, pochodzi od fizyczki i krytyczki technologii Ursuli Franklin: „Mapy są owocem umyślnego działania: mają być użyteczne, pomagać podróżnikom i zapełniać lukę między tym, co znane, a tym, co dotąd nieznane; są świadectwem wiedzy i mądrości zbiorowej”22.

Najlepsze mapy oferują kompendium otwartych dróg – powszechnie dostępnych sposobów poznawania – które można ze sobą łączyć i mieszać, tworząc nowe związki. Istnieją jednak również mapy dominacji, owe mapy narodowe, na których terytoria są wykrawane wzdłuż linii podziału władzy: od bezpośredniego wytyczania granic na spornych obszarach po ukazywanie kolonialnych szlaków imperialnych. Przywołując pojęcie atlasu, chcę pokazać, że potrzebny nam jest nowy sposób pojmowania imperiów sztucznej inteligencji. Potrzebujemy takiej teorii sztucznej inteligencji, która uwzględni państwa i korporacje napędzające badania, eksploatację złóż odciskającą piętno na planecie, masowe zbieranie danych oraz naznaczone nierównościami i coraz bardziej oparte na wyzysku praktyki zatrudnienia. To jest zmienna tektonika władzy w dziedzinie AI. Podejście topograficzne oferuje różnorodne perspektywy i skale, wykraczające poza abstrakcyjne obietnice sztucznej inteligencji czy najnowsze modele uczenia maszynowego. Celem jest zrozumienie sztucznej inteligencji w szerszym kontekście dzięki uwzględnieniu wielu różnych cyfrowych krajobrazów i ich wzajemnym powiązaniom23.

Atlasy odgrywają w tym przypadku także inną rolę. Dziedzina AI pragnie uchwycić planetę w formie czytelnej obliczeniowo. Nie jest to metafora, ale wyrażana wprost ambicja tego przemysłu, który tworzy i normalizuje własne mapy chwytające z lotu ptaka ruch, komunikację i pracę ludzi. Niektórzy naukowcy przyznają się do pragnienia podbicia świata i wyparcia alternatywnych form poznania. Profesor sztucznej inteligencji Fei-Fei Li pisze, że projekt ImageNet ma na celu „stworzenie pełnej mapy świata rzeczy”24. Russell i Norvig twierdzą w swoim podręczniku, że AI może być zastosowana „do każdego zadania intelektualnego, gdyż jest dziedziną uniwersalną”25. Woody Bledsoe, jeden z pomysłodawców AI i eksperymentator w dziedzinie rozpoznawania twarzy, wypowiedział się bardziej dosadnie: „W dłuższej perspektywie ludzie się przekonają, że sztuczna inteligencja to po prostu cała nauka”26. Chodzi więc o pragnienie tworzenia nie tyle jakiegoś atlasu świata, ile jednego atlasu – dominującego sposobu widzenia. Ten impuls kolonizacyjny skupia władzę w rękach AI: określa, w jaki sposób należy świat mierzyć i definiować, jednocześnie zaprzeczając, że mowa o działaniach w istocie politycznych.

Ta książka nie rości pretensji do uniwersalności, ale stanowi relację cząstkową i mam nadzieję, że kiedy czytelnik będzie mi towarzyszył na mojej drodze, stanie się dla niego jasne, jak kształtowały się moje poglądy. Spotkamy bardziej i mniej znane krajobrazy sztucznej inteligencji: kopalniane wyrobiska, długie korytarze pożerających energię centrów danych, repozytoria czaszek, bazy obrazów i oświetlone lampami fluorescencyjnymi magazyny. Wybrałam te miejsca nie tylko dlatego, że ilustrują materialną bazę sztucznej inteligencji i jej ideologii, lecz także po to, aby „oświetlić nieuchronnie subiektywne i polityczne aspekty tworzenia map i dostarczyć alternatywy dla podejść hegemonicznych, autorytatywnych, a często również znaturalizowanych i urzeczowionych” – jak pisze medioznawczyni Shannon Mattern27.

Modele służące do rozumienia i rozliczania systemów od dawna opierają się na ideałach przejrzystości. Jak pisałam razem z medioznawcą Mikiem Anannym, czasami utożsamia się możliwość widzenia systemu z wiedzą o tym, jak on działa i jak można go kontrolować28. Ta zasada ma jednak istotne ograniczenie. W przypadku AI nie mamy do czynienia z jedną czarną skrzynką, którą można otworzyć, czy z jakimiś tajemnicami, które można ujawnić, ale z licznymi splecionymi ze sobą systemami władzy. Pełna przejrzystość jest zatem niemożliwa. Lepiej zatem zrozumiemy rolę sztucznej inteligencji w świecie, gdy zajmiemy się jej architekturą materialną, środowiskami kontekstowymi i dominującą polityką, a także gdy prześledzimy ich rozmaite powiązania.

Mój sposób myślenia widoczny w tej książce ukształtowały wiedza o nauce i technologii, prawo i filozofia polityczna oraz moje prawie dziesięcioletnie doświadczenie zarówno w środowisku akademickim, jak i w przemysłowo-badawczym laboratorium sztucznej inteligencji. Przez te lata na moje postrzeganie świata miało wpływ wiele znakomitych współpracowników i grup, w których pracowałam – tworzenie map zawsze jest zadaniem zbiorowym i od tej reguły nie ma wyjątków29. Wyrażam wdzięczność naukowcom, którzy stworzyli nowe sposoby rozumienia systemów socjotechnicznych, w tym Geoffreyowi Bowkerowi, Benjaminowi Brattonowi, Wendy Chun, Lorraine Daston, Peterowi Galisonowi, Ianowi Hackingowi, Stuartowi Hallowi, Donaldowi MacKenzie, Achille’owi Mbembe, Alondrze Nelson, Susan Leigh Star i Lucy Suchman oraz wielu innym. W książce tej można znaleźć ślady moich licznych rozmów i lektur najnowszych prac autorów badających politykę technologii, w tym Marka Andrejevica, Ruhy Benjamin, Meredith Broussard, Simone Browne, Julie Cohen, Sashy Costanza-Chock, Virginii Eubanks, Tarletona Gillespie, Mar Hicks, Tunga-Hui Hu, Yuka Hui, Safiyi Umoja Noble i Astry Taylor.

Jak każda książka, także ta wzięła się z konkretnego życiowego doświadczenia, które wiąże się z pewnymi ograniczeniami. Ponieważ od dziesięciu lat mieszkam i pracuję w Stanach Zjednoczonych, skupiam się na przemyśle AI w zachodnich ośrodkach władzy. Moim celem nie było stworzenie kompletnego, globalnego atlasu – już sam tylko pomysł stworzenia czegoś takiego odwoływałby się do podboju i kontroli kolonialnej. Punkt widzenia każdego autora może być tylko cząstkowy, oparty na obserwacjach i interpretacjach lokalnych, co geografka środowiskowa Samantha Saville określa jako „geografię skromną”, uznającą konkretne perspektywy, zamiast zgłaszać pretensje do obiektywności lub ostateczności30.

Istnieje wiele scenariuszy przyszłego wykorzystania sztucznej inteligencji, tak jak jest wiele sposobów tworzenia atlasów. Rosnący zasięg systemów AI może się wydawać czymś nieuniknionym, ale tak naprawdę jest to rzecz dyskusyjna i nieprzesądzona. Wizje AI nie powstają autonomicznie, lecz są konstruowane na podstawie określonych przekonań i perspektyw. Najważniejsi projektanci współczesnego atlasu AI stanowią grupę niewielką i jednorodną. Mieszkają w zaledwie paru miastach i pracują w obecnie najbogatszym przemyśle. Podobnie jak średniowieczne europejskie mappae mundi, które przedstawiały nie tylko współrzędne, ale też idee religijne i koncepcje zapożyczone z kultury klasycznej, tworzone przez przemysł AI mapy są interwencjami politycznymi, a nie neutralnym odwzorowaniem świata. Ta książka zwraca się przeciwko kolonialnej logice tworzenia map i stara się uwzględniać różne historie, miejsca i bazy wiedzy, aby można było lepiej zrozumieć rolę AI we współczesnym świecie.

Mappa mundi Heinricha Büntinga, znana jako Mapa Büntinga w kształcie trójlistnej koniczyny, symbolizuje chrześcijańską Trójcę, z Jerozolimą w centrum świata

Źródło: Itinerarium Sacrae Scripturae (Magdeburg, 1581)

Topografie informatyki

Jak na początku trzeciej dekady XXI wieku konceptualizuje się i konstruuje sztuczną inteligencję? Jaki sens ma zwrot ku AI i jaka polityka ukrywa się w sposobie tworzenia przez nią map oraz interpretacji świata? Jakie są społeczne i materialne konsekwencje wykorzystywania AI i innych algorytmicznych systemów w procesach decyzyjnych instytucji społecznych, takich jak system edukacji, opieka zdrowotna, finanse, administracja rządowa, interakcje w miejscu pracy, systemy komunikacji lub wymiar sprawiedliwości? Ta książka nie rozwija opowieści o kodowaniu i algorytmach, najnowszych osiągnięciach widzenia komputerowego, przetwarzaniu języka naturalnego czy uczeniu przez wzmacnianie. Wiele innych pozycji traktuje o tych sprawach. Nie jest to również etnograficzny opis pojedynczej społeczności i tego, jak AI wpływa na jej doświadczenia związane z pracą, mieszkalnictwem lub medycyną – choć z pewnością takich opisów przydałoby się więcej.

Ta książka oferuje za to kompleksowe spojrzenie na sztuczną inteligencję jako przemysł wydobywczy. Współczesne systemy AI nie byłyby możliwe bez wielkoskalowej eksploatacji zasobów energetycznych i mineralnych planety, taniej siły roboczej i danych. Aby zrozumieć, jak to się odbywa, udamy się do wielu miejsc zdradzających mechanizmy AI.

Rozdział pierwszy rozpoczniemy od wizyty w kopalni litu w Nevadzie, jednego z wielu ośrodków, gdzie wydobywa się minerały niezbędne dla współczesnej informatyki. Górnictwo jest obszarem, w którym mamy do czynienia z najbardziej dosłowną wydobywczą polityką sztucznej inteligencji. Zapotrzebowanie przemysłu informatycznego na minerały ziem rzadkich, ropę naftową i węgiel jest ogromne, ale prawdziwych kosztów wydobycia sama branża nie ponosi. Budowa modeli przetwarzania języka naturalnego i widzenia komputerowego jest niezwykle energochłonna, a wyścig za coraz szybszymi i wydajniejszymi modelami wymusza stosowanie obliczeniowo kosztownych metod, które zwiększają ślad węglowy sztucznej inteligencji. Odwiedzimy naturalne i społeczne miejsca narodzin globalnych sieci informatycznych, przyglądając się temu, jak zmieniają oblicze planety – ostatnie lasy Malezji, które zostały zniszczone dla pozyskania lateksu, pierwsze transatlantyckie kable podmorskie i gigantyczne sztuczne jezioro pełne toksycznych odpadów w Mongolii Wewnętrznej.

Rozdział drugi ukazuje, jak ludzka praca tworzy sztuczną inteligencję. Spotkamy cyfrowych pracowników akordowych, nędznie opłacanych za mikroklikanie, aby systemy wykorzystujące dane wydawały się bardziej inteligentne niż w rzeczywistości31. Udamy się do magazynów Amazona, gdzie pracownicy muszą dotrzymać kroku algorytmicznemu rytmowi wielkiego logistycznego imperium, oraz poznamy chicagowskich pracowników zakładów mięsnych uwijających się na liniach rozbioru i wykrawania tusz, gdzie zwłoki zwierząt są poddawane wiwisekcji i przygotowywane do spożycia. Dowiemy się, co myślą pracownicy protestujący przeciwko sposobowi, w jaki systemy AI wzmagają inwigilację i kontrolę ze strony szefów.

Mówiąc o pracy, nie można nie wspomnieć o czasie. Dostosowanie czynności ludzkiej do powtarzalnych ruchów robotów i maszyn na linii produkcyjnej zawsze wiąże się z kontrolą ciał w czasie i przestrzeni32. Od wynalazku stopera po TrueTime Google’a – kontrola czasu jest podstawą zarządzania miejscem pracy. Technologie AI zarówno stawiają pewne wymagania, jak i stwarzają warunki umożliwiające coraz bardziej szczegółowe i dokładne zarządzanie czasem. Koordynacja nie jest możliwa bez coraz dokładniejszych informacji o tym, co, jak i kiedy robią ludzie.

Rozdział trzeci omawia rolę danych. Wszystkie dostępne publicznie materiały cyfrowe – w tym dane osobowe lub potencjalnie szkodliwe – gromadzone są jako dane treningowe dla modeli sztucznej inteligencji. Od początku lat 90. XX wieku powstają gigantyczne zbiory danych pełne selfie prywatnych osób, gestów, czynności związanych z prowadzeniem pojazdów, płaczu dzieci, rozmów na grupach dyskusyjnych, a wszystko to służy poprawianiu algorytmów wykonujących takie zadania, jak rozpoznawanie twarzy, języka czy wykrywanie obiektów. Gdy zbiory danych przestają być uważane za własność prywatną i stają się jedynie infrastrukturą, wówczas określone znaczenie lub kontekst obrazu bądź filmu przestają być ważne. Pomijając istotne problemy związane z ochroną prywatności i kapitalizmem inwigilacji, obecny sposób wykorzystywania danych w sztucznej inteligencji budzi także głęboki niepokój etyczny, metodologiczny i epistemologiczny33.

Jak wykorzystuje się dane? W rozdziale czwartym przyjrzymy się praktyce klasyfikacyjnej w systemach AI, którą socjolożka Karin Knorr Cetina nazywa „maszynerią epistemiczną”34. Przekonamy się, że nowoczesne systemy posługują się etykietami w celu przewidywania ludzkiego zachowania i że zwykle używają binarnego podziału płciowego, uogólnionych kategorii rasowych i problematycznych ocen charakteru czy zdolności kredytowej. Znak zajmuje miejsce systemu, zastępnik udaje rzeczywistość, a uproszczony model usiłuje naśladować nieskończenie złożoną ludzką podmiotowość. Na przykładzie klasyfikacji zobaczymy, że schematy techniczne wzmacniają hierarchie i pogłębiają niesprawiedliwość. Uczenie maszynowe okazuje się reżimem rozumowania normatywnego, który przyjmuje postać przemożnej racjonalności zarządczej.

Następnie wybierzemy się do miasteczek położonych na wzgórzach Papui-Nowej Gwinei, aby poznać historię rozpoznawania uczuć oraz przekonanie, że mimika jest kluczem do zrozumienia wewnętrznego stanu emocjonalnego. W rozdziale piątym poświęcimy uwagę twierdzeniu psychologa Paula Ekmana, że istnieje niewielki zbiór uniwersalnych stanów emocjonalnych, które można odczytywać bezpośrednio z twarzy. Firmy informatyczne obecnie wdrażają tę koncepcję w systemach rozpoznawania stanów afektywnych, których przyszła wartość rynkowa szacowana jest na co najmniej siedemnaście miliardów dolarów35. Wykrywanie emocji wywołuje jednak wiele naukowych kontrowersji, gdyż jest ono w najlepszym razie niepełne, a w najgorszym wprowadza w błąd. Pomimo wątpliwych założeń narzędzia te szybko znajdują zastosowanie w zatrudnianiu pracowników, systemach edukacyjnych i zadaniach policyjnych.

Z kolei w rozdziale szóstym przyjrzymy się temu, jak systemy AI stają się narzędziem władzy państwowej. Wojskowa przeszłość i teraźniejszość sztucznej inteligencji wpłynęły na kształt współczesnych praktyk inwigilacji, ekstrakcji danych i oceny ryzyka. Ścisłe związki między przemysłem informatycznym a wojskowością usiłuje się obecnie rozluźnić w imię przywrócenia suwerenności narodowej. Tymczasem wykorzystywane przez wywiad pozaprawne narzędzia upowszechniły się, przechodząc ze świata wojskowego do komercyjnej branży informatycznej, i są stosowane w klasach, na posterunkach policji, w zakładach i urzędach pracy. Logika militarna, która kształtowała systemy AI, teraz wyznacza sposób działania władz lokalnych, jeszcze mocniej wypaczając stosunki między państwem a obywatelem.

Ostatni rozdział dotyczy funkcjonowania AI jako struktury władzy łączącej infrastrukturę, kapitał i siłę roboczą. Od sterowanego przez algorytmy kierowcy Ubera przez inwigilowanego nielegalnego imigranta po najemców mieszkań komunalnych borykających się z systemami rozpoznawania twarzy zainstalowanymi w ich domach – systemy AI podlegają logice kapitału, policyjnej kontroli i militaryzacji, a takie połączenie jeszcze bardziej wzmacnia istniejące asymetrie władzy. Takie sposoby widzenia są oparte na bliźniaczych operacjach abstrakcji i ekstrakcji – abstrakcji od materialnych warunków ich powstawania i ekstrakcji coraz większej ilości informacji lub zasobów od tych, którzy mają najmniejsze pole do obrony.

Tę logikę można jednak podważać, tak jak można obalić systemy opresyjne. W miarę zmiany warunków na Ziemi należy wsłuchiwać się w apele o ochronę danych, prawa pracownicze, sprawiedliwość klimatyczną i równość rasową. Kiedy te skoordynowane ruchy na rzecz sprawiedliwości kształtują nasze rozumienie AI, możliwe stają się odmienne koncepcje polityki w skali planetarnej.

Ekstrakcja, władza i polityka

Sztuczna inteligencja jest więc ideą, infrastrukturą, przemysłem, formą sprawowania władzy i sposobem widzenia świata; jest także manifestacją wysoce zorganizowanego kapitału, wspieranego przez rozbudowane systemy ekstrakcji i logistyki, z łańcuchami dostaw oplatającymi cały ziemski glob. Wszystkie te rzeczy składają się na sztuczną inteligencję – dwuwyrazowe wyrażenie, w którym odwzorowuje się złożony zestaw oczekiwań, ideologii, pragnień i lęków.

Może się wydawać, że AI jest jakąś duchową siłą, bezcielesną mocą obliczeniową, ale w rzeczywistości systemy te nie mają w sobie nic abstrakcyjnego. Mówimy o fizycznej infrastrukturze odmieniającej oblicze Ziemi i jednocześnie przeobrażającej nasz sposób postrzegania i rozumienia świata.

Niezwykle ważne jest to, abyśmy umieli stawić czoła tym rozmaitym aspektom sztucznej inteligencji – jej plastyczności, chaotyczności i czasowo-przestrzennemu zasięgowi. Przystosowalność pojęcia sztucznej inteligencji, jej otwartość na rekonfiguracje oznacza, że można je na wiele sposobów wykorzystywać: może odnosić się do wszystkiego – od urządzeń konsumenckich, takich jak Amazon Echo, przez anonimowe systemy przetwarzania backendowego, wąskie i najeżone techniczną terminologią artykuły naukowe, po największe firmy informatyczne na świecie. Ale to również można wykorzystać. Szeroki zakres pojęcia sztucznej inteligencji pozwala nam rozważać wszystkie te elementy oraz ich ścisłe powiązanie: od strategii wywiadowczych po wielkoskalowe zbieranie danych; od koncentracji przemysłu informatycznego po geopolityczną rywalizację militarną; od zrujnowanego środowiska po trwałe formy dyskryminacji.

Nasze zadanie polega na uważnym obserwowaniu ewoluujących i plastycznych znaczeń terminu „sztuczna inteligencja” – pojemnika, do którego różne rzeczy są wkładane, a następnie z niego wyjmowane – to również bowiem należy do tej opowieści.

Najprościej mówiąc, AI stała się istotnym czynnikiem kształtującym wiedzę, komunikację i stosunki władzy. Rekonfiguracje dotyczą poziomu epistemologicznego, zasad sprawiedliwości, organizacji społecznej, politycznej ekspresji, kultury, rozumienia ludzkiego ciała, podmiotowości i tożsamości – kwestii tego, czym jesteśmy i czym możemy się stać. Ale pójdźmy dalej. Sztuczna inteligencja, która na nowo odwzorowuje i przeobraża świat, jest polityką uprawianą innymi środkami – choć rzadko mówi się o tym otwarcie. Tę politykę uprawiają Potęgi AI, czyli pół tuzina korporacji, które zdominowało wielkoskalowe obliczenia.

Wiele instytucji społecznych znajduje się obecnie pod wpływem tych narzędzi i metod, które kształtują sposoby oceniania i decyzje pociągające za sobą złożone konsekwencje. Budowa technokratycznej władzy trwa od dawna, ale teraz proces ten uległ przyspieszeniu. Przyczyną jest po części koncentracja kapitału w czasach planów oszczędnościowych i outsourcingu, które prowadzą również do trudności finansowych instytucji opieki społecznej będących niegdyś przeciwwagą dla rynku. Dlatego musimy się zmierzyć ze sztuczną inteligencją jako potęgą polityczną, gospodarczą, kulturową i naukową. Jak zauważyli Alondra Nelson, Thuy Linh Tu i Alicia Headlam Hines: „Spory o technologię zawsze mają związek z szerszymi zmaganiami o ekonomiczną mobilność, strategiami politycznymi i budowaniem wspólnoty”36.

Znajdujemy się w momencie krytycznym, który wymaga postawienia trudnych pytań o to, jak jest tworzona i wdrażana sztuczna inteligencja. Musimy zapytać: czym jest w istocie AI? Jakie formy polityki faworyzuje? Czyim interesom służy i kto ponosi największe ryzyko? W jakich dziedzinach trzeba ograniczyć wykorzystanie AI? Nie znajdziemy łatwych odpowiedzi. Ale nie jest też tak, że nie istnieją rozwiązania, a kierunek rozwoju jest przesądzony – dystopijne myślenie może paraliżować zdolność do czynu i uniemożliwić naglącą interwencję37. Jak pisze Ursula Franklin: „Żywotność technologii, tak jak demokracji, ostatecznie zależy od kultywowania sprawiedliwości i narzucania władzy ograniczeń”38.

Pragnę w tej książce wykazać, że omawianie podstawowych problemów AI i obliczeń planetarnych wymaga zestawienia ze sobą zagadnień władzy i sprawiedliwości: epistemologii z prawami pracowniczymi, ekstrakcji zasobów z ochroną danych, nierówności rasowych ze zmianami klimatycznymi. Musimy w tym celu poszerzyć wiedzę o tym, co się dzieje w imperiach AI, pojąć, o co toczy się gra, i podejmować wspólnie lepsze decyzje kształtujące przyszłość.